KServe:下一代 KFServing

KServe 博客文章

作者:Dan Sun 和 Animesh Singh,代表 Kubeflow Serving 工作组

KFServing 现在是 KServe

我们很高兴宣布 KFServing 的新篇章。经过与 Kubeflow 项目指导委员会的协调,KFServing GitHub 仓库现已转移到由 Kubeflow Serving 工作组负责人负责的独立 KServe GitHub 组织下。

项目已从 KFServing 更名为 KServe,我们计划在今年晚些时候让项目从 Kubeflow 项目中独立出来。

KFServing 由 Google、IBM、Bloomberg、NVIDIA 和 Seldon 于 2019 年协作开发,并于 2019 年初发布为开源项目。该项目旨在提供以下特性:

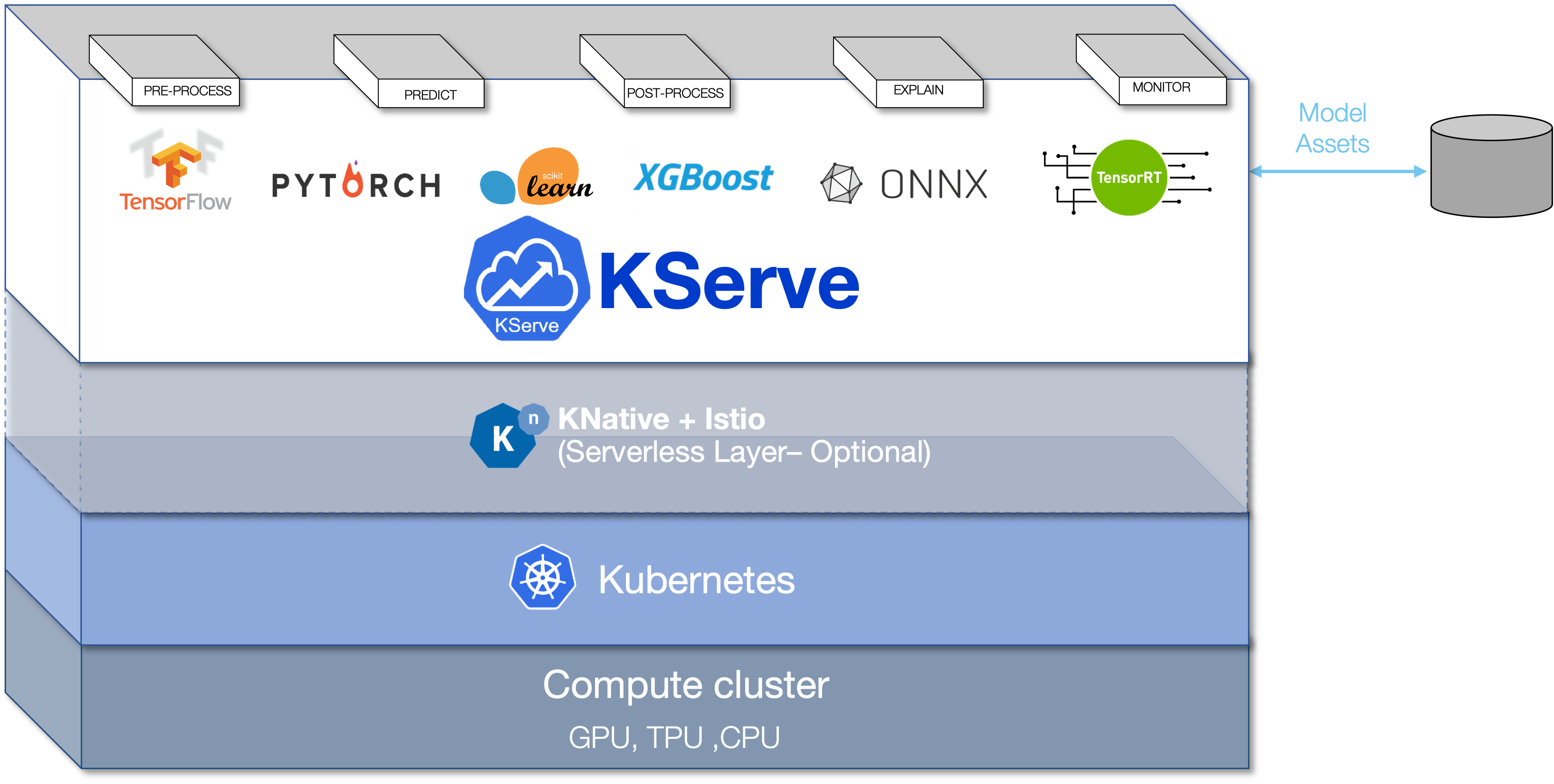

- 一个简单而强大的 Kubernetes 自定义资源,用于在生产环境中跨 ML 框架部署机器学习 (ML) 模型。

- 提供高性能、标准化的推理协议。

- 根据实时流量模式提供无服务器推理,支持 CPU 和 GPU 上的“零伸缩”(Scale-to-zero)。

- 为生产环境 ML 模型服务提供完整的解决方案,包括预测、预处理/后处理、可解释性和监控。

- 支持大规模部署数千个模型以及多模型的推理图能力。

创建 KFServing 是为了解决组织在生产环境中部署和监控机器学习模型所面临的挑战。在发布开源项目后,我们看到了对该软件需求的爆炸式增长,这带来了广泛的采用和社区的发展。此后,项目的范围不断扩大,我们在此过程中开发了多个组件,包括我们自己不断增长的文档体系,这些文档需要拥有自己的网站和独立的 GitHub 组织。

下一步计划

在接下来的几周内,我们将在 Kubeflow 项目之外发布 KServe 0.7,并将提供关于如何以最小中断从 KFServing 迁移到 KServe 的更多细节。在 KServe 0.7 发布后的六个月内,仍然支持 KFServing 0.5.x/0.6.x 版本。我们还在努力集成核心 Kubeflow API 和标准,以便进行一致性认证计划。

对于贡献者,请遵循 KServe 开发者和文档贡献指南进行代码或文档贡献。我们很高兴与您合作,共同使 KServe 变得更好,并促进其被越来越多的用户采用!

KServe 重要链接

贡献者致谢

我们要感谢所有为这次过渡做出贡献的 KServe 贡献者!